Екатерина Коваленко

Блогеры-нейросети уже не фейк. Ютуб полон каналами нейросетей! Показываю, как они реалистичны!

Для просмотра ссылки Войди или Зарегистрируйся

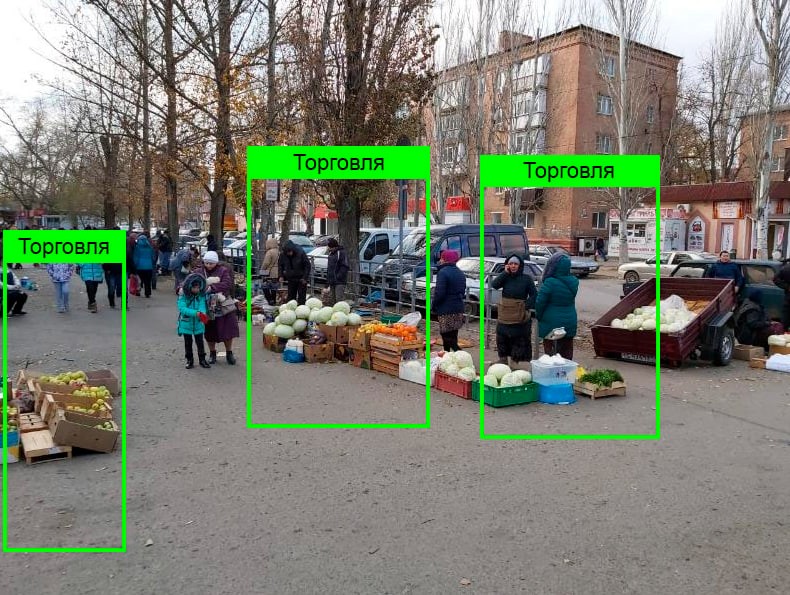

Подмосковье сообщило данные о выявлении несанкционированной торговли с помощью ИИ

Блогеры-нейросети уже не фейк. Ютуб полон каналами нейросетей! Показываю, как они реалистичны!

Для просмотра ссылки Войди или Зарегистрируйся

Подмосковье сообщило данные о выявлении несанкционированной торговли с помощью ИИ

Число камер, с помощью которых ИИ-система выявляет несанкционированную торговлю на подмосковных улицах, за год увеличилось в 30 раз до более 6,6 тысячи видеокамер, сообщили D-Russia.ru в Мингосуправления Московской области в среду.

По словам главы министерства Надежды Куртяник, ИИ-контроль уличной торговли внедрён во всех муниципалитетах. Вероятность ошибки идентификации изображения таких точек – 3%. За год устранены более 930 точек стихийной торговли.

Нейросеть определяет такие объекты по ряду характеристик, включая их расположение, внешний вид, и даже «характер и условия предлагаемых товаров», сказано в сообщении. Информация передаётся в местную администрацию.

Ответственный исполнитель едет на место предполагаемой торговли и осматривает его, подтверждает или опровергает факт нарушения с помощью мобильного приложения «Проверки Подмосковья».

Источник

Для просмотра ссылки Войди или Зарегистрируйся

Meta✴ закроет европейцам доступ к будущим ИИ-моделям

Следующая мультимодальная ИИ-модель Meta✴, как и другие будущие модели, будут недоступны клиентам в Европейском Союзе из-за отсутствия ясности со стороны регулирующих органов, сообщила компания ресурсу Axios.

Источник изображения: OpenClipart-Vectors/Pixabay

«Мы выпустим мультимодальную модель Llama в ближайшие месяцы, но не в ЕС из-за непредсказуемого характера европейской нормативно-правовой среды», — указано в заявлении Meta✴, направленном Axios. В Meta✴ также сообщили, что европейские компании не смогут использовать её мультимодальные модели, даже если те выпускаются под открытой лицензией. Кроме того, компании из других стран не смогут предлагать в Европе продукты и услуги, использующие новые мультимодальные модели от Meta✴.

Аналогичным образом поступила Apple, сообщившая в прошлом месяце, что функции Apple Intelligence будут недоступны в Европе из-за требований Закона о цифровых услугах (DMA), выполнение которых может привести «к снижению безопасности пользовательских данных и их приватности».

Meta✴ также планирует выпустить в ближайшее время более крупную текстовую версию модели Llama 3, которая будет доступна компаниям в ЕС.

Как полагает ресурс Axios, проблема Meta✴ связана скорее с тем, как она, возможно, использует для обучения модели данные европейских клиентов, нарушая тем самым Общий регламент по защите данных (General Data Protection Regulation, GDPR) ЕС. Компанию уже обвиняли в незаконном массовом сборе персональных данных европейских пользователей.

В мае Meta✴ объявила о планах использовать общедоступные публикации пользователей Facebook✴ и Instagram✴ для обучения будущих моделей, в связи с чем отправила более 2 млрд уведомлений пользователям в ЕС. Но затем была вынуждена отказаться от этого из-за запрета Ирландской комиссии по защите данных (DPC) и Управления комиссара по информации Великобритании (ICO).

Источник:

Для просмотра ссылки Войди или Зарегистрируйся

Китайские цензоры привьют ИИ социалистические ценности

Китайские чиновники осуществляют тщательное тестирование разрабатываемых местными компаниями больших языковых моделей — передовых систем искусственного интеллекта — чтобы убедиться, что те «воплощают базовые социалистические ценности», сообщает Financial Times.

Источник изображения: 文 邵 / pixabay.com

Государственная канцелярия интернет-информации КНР (Cyberspace Administration of China, CAC) обязала крупные технологические компании и стартапы в области ИИ, в том числе ByteDance, Alibaba, Moonshot и 01.AI, принять участие в правительственном тестировании их моделей. Процедура включает в себя пакетный сбор ответов на целый ряд вопросов, многие из которых связаны с политическим курсом Китая и с главой государства Си Цзиньпином (Xi Jinping). Работа выполняется чиновниками в местных отделениях ведомства и также включает в себя проверку массивов данных, которые использовались при обучении моделей. Примерно двадцать лет назад в стране начал работать «Великий китайский брандмауэр», заблокировавший населению доступ к ресурсам с информацией, которую власти считают недопустимой, — теперь Пекин вводит самые жёсткие в мире меры регулирования ИИ и создаваемого им контента.

Приводится пример китайского стартапа в области ИИ, чья большая языковая модель прошла экспертизу в ведомстве только со второго раза — причина отказа в первый раз была не до конца ясна, и разработчикам пришлось консультироваться с более удачливыми и понятливыми коллегами. Весь процесс занял несколько месяцев. Для разработчиков задача осложняется тем, что приходится использовать в обучении ИИ большой объём англоязычных материалов, которые в идеологическом плане сильно отличаются от контента на китайском. Фильтрация начинается с отсеивания проблемной информации из обучающих данных и создания базы данных требующих особого внимания слов. В феврале власти страны опубликовали руководство для компаний, работающих в области ИИ: в документе говорится о необходимости собрать базу из нескольких тысяч слов и вопросов, которые противоречат «базовым социалистическим ценностям» — это может быть «подстрекательство к подрыву государственной власти» или «подрыв национального единства».

Источник изображения: Nicky / pixabay.com

Пользователи китайских чат-ботов с ИИ уже ощутили результаты этой работы. Большинство систем отказывается отвечать на вопросы, например, о событиях на площади Тяньаньмэнь 4 июня 1989 года или о сходстве главы государства с Винни-Пухом — чат-боты Baidu Ernie и Alibaba Tongyi Qianwen делают это под различными благовидными предлогами. При этом Пекином был запущен альтернативный чат-бот, ответы которого опираются на работы Си Цзиньпина и другую официальную литературу, предоставленную канцелярией интернет-информации. Но одной только цензуры китайским чиновникам недостаточно — ИИ не следует уклоняться от разговора на любые политические темы. Согласно действующему стандарту, большая языковая модель не должна отклонять более 5 % вопросов.

Разработчики же, пытаясь избежать проблем с властями, всё равно действуют радикально. «Во время тестирования [чиновниками модели] должны отвечать, но после выхода за ними никто не надзирает. Чтобы избежать возможных неприятностей, у некоторых крупных моделей введён полный запрет на темы, связанные с президентом Си», — рассказал сотрудник одной шанхайской компании. Создаются дополнительные механизмы для контроля ответов ИИ, принцип работы которых напоминает фильтры спама в системах электронной почты. А больше всех в идеологическом плане преуспела модель, разработанная компанией ByteDance (владеет TikTok), — исследователи Фуданьского университета присвоили ей высший рейтинг безопасности в 66,4 %. Для сравнения, OpenAI GPT-4o в том же тесте набрала 7,1 %.

На недавней технической конференции Фан Биньсин (Fang Binxing), известный как создатель «Великого китайского брандмауэра», рассказал, что разрабатывает систему протоколов безопасности для больших языковых моделей, которая, как он надеется, будет повсеместно использоваться местными создателями ИИ. «Общедоступным крупным прогностическим моделям нужно больше, чем просто документация по безопасности — им нужен мониторинг безопасности в реальном времени», — пояснил он.

Источник:

Для просмотра ссылки Войди или Зарегистрируйся

Google, Nvidia, Intel, OpanAI и другие IT-гиганты создали «Коалицию за безопасный искусственный интеллект»

Google, OpenAI, Microsoft, Amazon, Nvidia, Intel и другие крупные игроки рынка искусственного интеллекта объявили о создании «Коалиции за безопасный искусственный интеллект» (CoSAI). Инициатива направлена на решение проблемы «фрагментированности ландшафта безопасности ИИ» путём предоставления доступа к методологиям, платформам и инструментам с открытым исходным кодом.

Источник изображения: oasis-open.org

Какое именно влияние хочет оказать CoSAI на индустрию искусственного интеллекта — неизвестно. Вероятно, вопросы защиты конфиденциальной информации и дискриминационные проблемы ИИ станут одними из направлений работы этой организации.

К инициативе CoSAI также присоединились компании IBM, PayPal, Cisco и Anthropic. CoSAI будет существовать в рамках «Организации по развитию стандартов структурированной информации» (OASIS), некоммерческой группы, которая способствует развитию открытых стандартов. CoSAI отмечает три основных направления деятельности: разработка эффективных практик обеспечения безопасности ИИ, решение общих проблем в области ИИ, а также безопасность приложений на базе искусственного интеллекта.

«Мы используем ИИ уже много лет и видим какую пользу он может приносить. Но мы также признаём его возможности, которые могут быть интересы злоумышленникам. CoSAI призвана помочь малым и крупным организациям безопасно и ответственно интегрировать и использовать преимущества ИИ в своих экосистемах, одновременно снизив все потенциально связанные с этим риски», — говорится в заявлении Хизер Адкинс (Heather Adkins), вице-президента Google по безопасности.

Источник:

Для просмотра ссылки Войди или Зарегистрируйся

Экстремистские соцсети автоматически транслируют сексистский контент – результат эксперимента

Алгоритмы социальных сетей Facebook и Instagram (принадлежат экстремистской Meta) настроены таким образом, чтобы автоматически рекомендовать пользователям женоненавистнические и сексистские материалы, написала в субботу газета The Guardian со ссылкой на эксперимент австралийских коллег.

С экспериментальной целью журналисты создали новые аккаунты, принадлежащие якобы 24-летним мужчинам, в Facebook и Instagram. Для регистрации использовались свежесозданные электронные адреса, в почтовых ящиках которых, писем не было, и только что приобретённые смартфоны, которые не использовались ни для звонков, ни для веб-сёрфинга, ни для исполнения мобильных приложений.

Facebook были доступны данные лишь о типе смартфона пользователя и его местоположении (Мельбурн). Для создания учётной записи в Instagram пришлось подписаться на пять других аккаунтов, в частности страницу премьер-министра и местной фотомодели.

Спустя три месяца рекомендации Facebook состояли из мемов вперемешку с «чрезвычайно сексистским женоненавистническим контентом». Страница «Интересное» в Instagram была заполнена материалами с полуголыми женщинами.

Источник

Для просмотра ссылки Войди или Зарегистрируйся

Доказано: тесты CAPTCHA бесполезны. Они не защищают от ботов, зато отнимают у людей время, эквивалентное миллиардам долларов

Исследование показало, что прохождение тестов CAPTCHA всех разновидностей отнимает у людей трудоспособного возраста сотни миллионов часов времени, в том числе и рабочего. Их оценили в миллиарды долларов США. При этом, уверены авторы исследования, эти технологии не решают единственную задачу, ради которой они в принципе создавались – они не защищают от ботов. К тому же CAPTCHA и его производные – еще один источник денег для Google.

Сервис, который не работает

Исследователи из Калифорнийского университета в Ирвайне выяснили, что сервис защиты об ботов reCAPTCHA v2, созданный Google, не только не работает, но еще и вредит мировой экономике, пишет The Register. В отличие от reCAPTCHA первой версии, где людям требуется искать на картинках гидранты, лодки, автобусы и автомобили, reCAPTCHA v2 предлагает просто нажать на чекбокс и поставить в нем галочку. Казалось бы, просто действие, не требующее много времени, но, согласно отчету исследователей, люди потратили на reCAPTCHA v2 819 млн часов своего времени, в том числе и рабочего, за все время существования этого теста, что соответствует не менее $6,1 млрд в виде заработной платы, по подсчетам авторов исследования.

Ученые утверждают, что reCAPTCHA v2 собирает информацию, одновременно расходуя время людей стоимостью в миллиарды долларов. Также они утверждают, что сервис не выполняет свою единственную функцию – не защищает от ботов.

Но нельзя не отметить, что reCAPTCHA v2 – не самая современная версия этой защиты. CNews писал, что в 2018 г. вышла версия v3, которая работает в фоновом режиме и не требует никаких действий от пользователя.

Karen Grigorean / Unsplash

Аллюзия на reCAPTCHA v1. Этот тест годами ежедневно раздражает миллионы людей по всему миру

История теста началась в 1997 г., когда он назывался просто CAPTCHA и предлагал пользователям написать текст, который они видят на изображении. В 2007 г. вышла версия reCAPTCHA, а через два года ее купил Google. reCAPTCHA v2 вышла в 2014 г., а спустя четыре года появилась reCAPTCHA v3 и одновременно была прекращена поддержка оригинальной reCAPTCHA.

Но даже несмотря на то, что reCAPTCHA v3 уже шесть лет, тест reCAPTCHA v2 по-прежнему широко распространен в интернете. По подсчетам The Register, он используется на 3 млн веб-сайтов по всему миру.

Искусственный интеллект все испортил

На начальных этапах CAPTCHA и его производные очень хорошо справлялись с отсевом ботов, но в современных реалиях со своей работой они уже не справляются. Как пишет The Register, этому способствует развитие и повсеместное внедрение искусственного интеллекта – вооруженные им боты могут отвечать на вопросы CAPTCHA почти так же хорошо, как люди.

Авторы исследования под названием «Ошеломленный и растерянный: крупномасштабное исследование reCAPTCHAv2 на реальных пользователях» (Dazed & Confused: A Large-Scale Real-World User Study of reCAPTCHAv2) утверждают, что от всех видов этого сервиса следует поскорее отказаться, притом по целому списку причин. Помимо неспособности противостоять искусственному интеллекту все виды CAPTCHA не нравятся пользователям. К тому же, по их словам, эти тесты требуют больших затрат времени и ресурсов центра обработки данных.

Не функционировать и следить за всеми

Исследователи отдельно отметили, что с помощью CAPTCHA Google следит за пользователями. «Я считаю, что истинная цель reCAPTCHA – в сборе информации и труда пользователей с веб-сайтов, – заявил The Register Эндрю Сирлз (Andrew Searles), недавно получивший докторскую степень и являющийся ведущим автором исследования. – Если вы верите, что reCAPTCHA защищает ваш сайт, вас обманули. Кроме того, это ложное чувство безопасности сопряжено с огромными затратами человеческого времени и конфиденциальности».

В отчете ученых отмечается, что еще в 2016 г. исследователям удалось обойти головоломки с изображениями reCAPTCHA v2 в 70% случаев. Задача с флажком reCAPTCHA v2 еще более уязвима - исследователи утверждают, что ее можно обойти в 100% случаев.

У reCAPTCHA v3 дела обстоят не лучше. В 2019 г. исследователи разработали алгоритм, который позволяет преодолеть этот тест в 97% случаев.

«Версия 3 лучше, чем v2, поскольку она чисто поведенческая, – сказал The Register соавтор исследования Джин Цудик (Gene Tsudik), профессор компьютерных наук в Калифорнийском университете в Ирвайне. – Но, как и v2, это не настоящая CAPTCHA – то есть она не «публичная» и не тест Тьюринга. Это метод, основанный на поведенческой аналитике, который присваивает баллы поведению пользователя. Таким образом, это вмешательство в конфиденциальность, поскольку мы (общественность) не знаем, как это работает. По сути, это "черный ящик"».

«Эти системы были побеждены еще до того, как их внедрили в глобальном масштабе», – добавил Эндрю Сирлз. – Проблемы выбора изображений были решены компьютерами в 2009 г. (но добавлены Google в 2014 г.). Сторонние файлы cookie reCATPCHA для поведенческого обнаружения ввели уязвимость "кликджекинга" , что упростило их автоматический обход».

Наглядное доказательство

Предоставленная авторами статьи информация основана на исследовании пользователей, которое проводилось в течение 13 месяцев в 2022 и 2023 гг. Было зафиксировано около 9141 сеанса reCAPTCHAv2 у невольных участников и проанализировано совместно с опросом, в котором приняли участие 108 человек.

Респонденты дали головоломке с флажками reCAPTCHA v2 оценку 78,51 из 100 по шкале удобства использования системы, в то время как головоломка с изображением (v1) получила оценку всего 58,90. «Результаты показывают, что 40% участников посчитали версию с изображением (v1 – прим. CNews) раздражающей (или очень раздражающей), в то время как меньше 10% посчитали таковой версию с флажком (v2 – прим. CNews)», – говорится в исследовании.

Кто заплатит за все

В совокупности взаимодействие с reCAPTCHA влечет за собой значительные затраты, часть которых фиксирует Google, пишет The Register. «С точки зрения затрат мы оцениваем, что за 13 лет использования reCAPTCHA на нее было потрачено 819 млн часов человеческого времени, что соответствует не менее $6,1 млрд в виде заработной платы», – утверждают авторы в своей статье. Это примерно $7,5 в час, что примерно соответствует минимальной ставке оплаты труда в США.

«Трафик, полученный в результате reCAPTCHA, потребил 134 петабайта пропускной способности, что эквивалентно примерно 7,5 млн кВтч энергии, что соответствует 7,5 млн фунтов CO2. Кроме того, Google потенциально получил прибыль в размере $888 млрд от файлов cookie (созданных в ходе сеансов reCAPTCHA – прим. CNews) и $8,75–32,3 млрд за каждую продажу своего общего набора маркированных данных».

На вопрос о том, являются ли затраты, которые Google перекладывает на пользователей reCAPTCHA в виде времени и усилий, необоснованными или эксплуататорскими, Сирлз указал на оригинальный документ по CAPTCHA, написанный Луисом фон Ан (Luis von Ahn), Мануэлем Блюмом (Manuel Blum)и Джоном Лэнгфордом (John Langford ), в котором есть раздел под названием «Кража циклов у людей» (Stealing cycles from humans).

«Этот раздел, в целом, обобщает, как CAPTCHA создает эксплуататорскую экономику функций, где коварные боты могут призывать людей выполнять для них задания, – сказал Сирлз. – Неразумно заставлять кого-то решать задачу безопасности, когда нет никакой защищенности».

Сирлз утверждает, что расходы должен нести Google, а не пользователи веб-сайта. «Если сервис заявляет, что обнаруживает ботов, то он должен их обнаруживать, особенно если это платный сервис», – заявил он.

«Можно сделать вывод, что истинная цель reCAPTCHA v2 – бесплатная маркировка изображений и отслеживание cookie для рекламы и получения прибыли от данных, маскирующаяся под службу безопасности», – говорится в статье.

Представители Google не ответили на вопросы издания.

Источник

Для просмотра ссылки Войди или Зарегистрируйся

Microsoft добавила сгенерированные ИИ сводки в результаты поиска Bing

Гонка по внедрению функций на основе искусственного интеллекта в поисковые системы набирает обороты, и Microsoft на этом фоне запустила новый инструмент для своего поисковика Bing. На этой неделе софтверный гигант развернул функцию, которая в ответ на пользовательский запрос в Bing выдаёт сводку, сгенерированную с помощью ИИ. На данном этапе предварительная версия функции доступна ограниченному числу пользователей.

Источник изображения: Rubaitul Azad / unsplash.com

Вместе с объявлением о запуске новой функции Microsoft опубликовала несколько примеров того, как она работает. Сгенерированный нейросетью текст ответа на запрос дополняется ссылками на источники, на основе которых была сформирована сводка. В дополнение к этому имеется раздел с сопутствующей информацией. К примеру, сводка в ответ на запрос «сколько живут слоны» дополняется видеороликами, в которых рассказывается о факторах, влияющих на продолжительность жизни слонов. После раздела с информацией, сгенерированной нейросетью, располагаются обычные результаты поиска по запросу пользователя.

К сожалению, на данный момент функция ИИ-поиска в Bing обрабатывает лишь «небольшой процент пользовательских запросов» и недоступна всем желающим. «Мы постепенно внедряем эту функцию и не спешим, собираем отзывы, тестируем, учимся и работаем над созданием качественного продукта, прежде чем сделать функцию доступной широкой аудитории», — говорится в сообщении Microsoft. Вероятно, Microsoft не хочет спешить с массовым внедрением новой функции, чтобы избежать проблем, с которыми столкнулась Google, которая ранее в этом году добавила в свой поисковик аналогичный ИИ-инструмент, зачастую формировавший не самые корректные ответы на пользовательские запросы.

Источник:

Для просмотра ссылки Войди или Зарегистрируйся

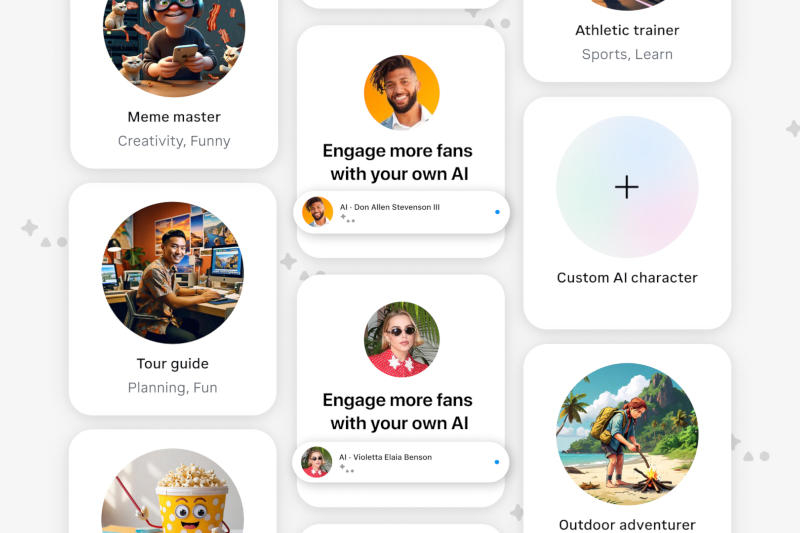

Пользователи Instagram✴ теперь могут создавать свои ИИ-копии

Meta✴ предложила всем американским пользователям возможность создавать с помощью инструмента с искусственным интеллектом AI Studio свои виртуальные копии в Instagram✴ и веб-интерфейсе. ИИ сможет общаться от имени блогеров и владельцев бизнес-страниц с подписчиками в чатах или в комментариях к публикациям.

Источник изображения: Meta✴

Работу с AI Studio можно начать либо через веб-интерфейс, либо прямо в Instagram✴, запустив в приложении новую «переписку с ИИ». Настройка ИИ осуществляется при помощи дополнительного обучения на контенте в Instagram✴; можно задать темы, которых следует избегать, и ссылки, которыми можно поделиться. Есть функции автоответов и возможность указать, с какими учётными записями разрешено взаимодействовать. В AI Studio можно также создавать совершенно новых ИИ-персонажей, которые впоследствии разворачиваются в приложениях Meta✴ — впоследствии они смогут выставляться как в магазине OpenAI, где поработать с ними смогут все желающие.

В Meta✴ понимают, что генеративный ИИ непредсказуем, и виртуальная версия знаменитости может наговорить того, что её реальный прототип не сказал бы никогда. Это, конечно, будет случаться даже вопреки множеству защитных инструментов, которые есть в AI Studio, поэтому ИИ-профили будут чётко отмечаться во всех местах своего присутствия. Компания опубликовала подробное руководство по созданию ИИ-профиля, и бремя перечисления закрытых тем возлагается на его создателя персонажа, а не саму Meta✴. Можно, например, запретить ИИ отвечать на вопрос о том, стоит ли вкладываться в криптовалюту — в этой области до сих пор слишком много мошенников, которые паразитируют на образах знаменитостей.

Источник:

Для просмотра ссылки Войди или Зарегистрируйся

:no_upscale()/imgs/2024/10/30/17/6641391/3486b01ed46b51451c09bc15c0c8225f210c33f1.webp)

:no_upscale()/imgs/2024/10/30/17/6641390/bfb6d604e780f52e71b6eebba095f563a8a169b8.png)